blog.game-programmer.jp

上の記事の続きです。

2.IMPLEMENTATION

This section describes the structure of and rationale underlying Spanner’s implementation. It then describes the directory abstraction, which is used to manage replication and locality, and is the unit of data movement. Finally, it describes our data model, why Spanner looks like a relational database instead of a key-value store, and how applications can control data locality.

2. 実装

このセクションでは、Spannerの実装と設計の根拠について説明します。 次に、レプリケーションとロケーション管理に使用され、データ移動の単位でもあるディレクトリ抽象化について説明します。 最後に、データモデル、なぜSpannerがキーバリューストアではなくリレーショナルデータベースのように見えるのか、そしてアプリケーションがデータのロケーションをどのように制御できるのかについて説明します。

A Spanner deployment is called a universe. Given that Spanner manages data globally, there will be only a handful of running universes. We currently run a test/playground universe, a development/production universe, and a production-only universe.

Spannerのデプロイメントはユニバースと呼ばれます。 Spannerがデータをグローバル規模で管理していることを考えると、実行中のユニバース数はごく少ないものになります。 我々は現在、test/playground、development/production、production-onlyの3つのユニバースを運用しています。

Spanner is organized as a set of zones, where each zone is the rough analog of a deployment of Bigtable servers [Chang et al. 2008]. Zones are the unit of administrative deployment. The set of zones is also the set of locations across which data can be replicated. Zones can be added to or removed from a running system as new datacenters are brought into service and old ones are turned off, respectively. Zones are also the unit of physical isolation: there may be one or more zones in a datacenter, for example, if different applications’ data must be partitioned across different sets of servers in the same datacenter.

Spannerはゾーンのセットとして編成されています。各ゾーンはBigtableに似ています[Chang et al. 2008]。 ゾーンはデプロイメントの管理単位です。 ゾーンのセットは、データをレプリケーションできるロケーションのセットでもあります。 データセンターの新規稼働や停止に応じて、実行中のシステムにゾーンを追加したり削除したりすることができます。 ゾーンは物理的な分離単位でもあります。例えば、異なるアプリケーションのデータを同じデータセンターの異なるサーバー群に格納する必要がある場合は、データセンターには複数のゾーンが存在することがあります。

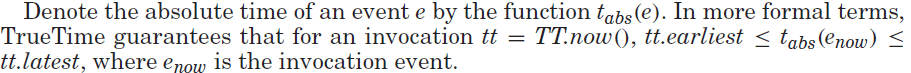

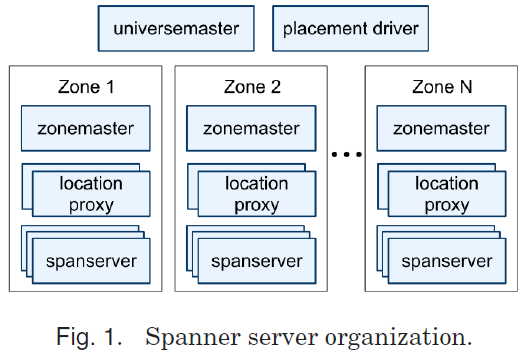

Figure 1 illustrates the servers in a Spanner universe. A zone has one zonemaster and between one hundred and several thousand spanservers. The former assigns data to spanservers; the latter serve data to clients. The per-zone location proxies are used by clients to locate the spanservers assigned to serve their data. The universe master and the placement driver are currently singletons. The universe master is primarily a console that displays status information about all the zones for interactive debugging. The placement driver handles automated movement of data across zones on the timescale of minutes. The placement driver periodically communicates with the spanservers to find data that needs to be moved, either to meet updated replication constraints or to balance load. For space reasons, we will only describe the spanserver in any detail.

図1は、ユニバース内のサーバーを示しています。 ゾーンには1つのゾーンマスターと百から数千のスパンサーバーがあります。 ゾーンマスターはデータをスパンサーバーに割り当てます。 スパンサーバーはクライアントにデータを提供します。 ゾーンごとのロケーションプロキシは、クライアントが割り当てられたスパンサーバーを見つけるために使用されます。 ユニバースマスターとプレイスメントドライバは現在シングルトンです。 ユニバースマスターは、主にゾーンに関するインタラクティブなデバッグ用途のステータス情報を表示するコンソールです。 プレイスメントドライバは、数分の時間規模でのゾーン間データ移動を処理します。 プレイスメントドライバはスパンサーバーと定期的に通信して、更新時のレプリケーション制約を満たすために、または負荷のバランスをとるために、移動する必要のあるデータを検索します。 スペース上の理由から、スパンサーバーについてのみ詳細に説明します。

2.1. Spanserver Software Stack

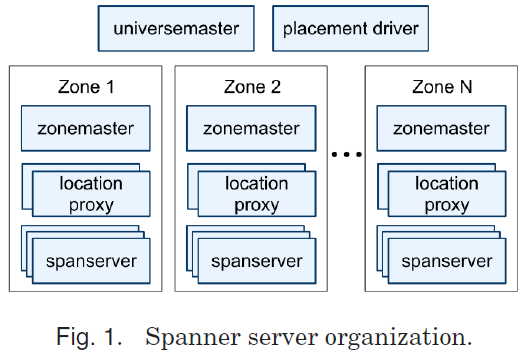

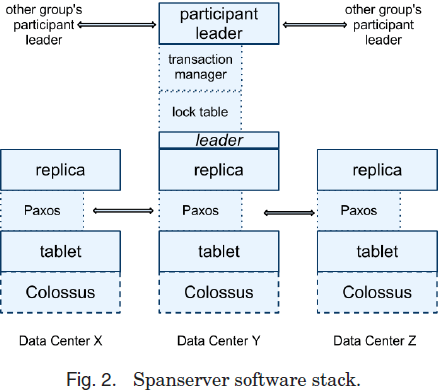

This section focuses on the spanserver implementation to illustrate how replication and distributed transactions have been layered onto our Bigtable-based implementation. The software stack is shown in Figure 2. At the bottom, each spanserver is responsible for between 100 and 1000 instances of a data structure called a tablet. A tablet is similar to Bigtable’s tablet abstraction, in that it implements a bag of the following mappings.

(key:string, timestamp:int64) → string

Unlike Bigtable, Spanner assigns timestamps to data, which is an important way in which Spanner is more like a multiversion database than a key-value store. A tablet’s state is stored in a set of B-tree-like files and a write-ahead log, all on a distributed file system called Colossus (the successor to the Google File System [Ghemawat et al. 2003]).

2.1 スパンサーバーのソフトウェアスタック

このセクションでは、スパンサーバーのレプリケーションと分散トランザクションの実装が、Bigtableベースの実装上にどのように階層化されているのかを説明します。 図2にソフトウェアスタックが示されています。各スパンサーバーは、タブレットと呼ばれるデータ構造のインスタンス100〜1000個の処理を担当します。タブレットは、Bigtableのタブレット抽象化と似ており、次のマッピングデータを保持しています。

(key:string, timestamp:int64) → string

Bigtableと異なり、Spannerはタイムスタンプをデータに割り当てます。これは、Spannerがキーバリューストアよりもむしろマルチバージョンデータベースに近い重要な要素です。 タブレットの状態は、Bツリーライクな形式のファイルセットと先行書き込みログに格納されています。これらはすべて、Colossus(Google File System[Ghemawat et al. 2003]の後継プロダクト)という分散ファイルシステム上にあります。

To support replication, each spanserver implements a single Paxos state machine on top of each tablet. (An early Spanner incarnation supported multiple Paxos state machines per tablet, which allowed for more flexible replication configurations. The complexity of that design led us to abandon it.) Each state machine stores its metadata and log in its corresponding tablet. Our Paxos implementation supports long-lived leaders with time-based leader leases, whose length defaults to 10 seconds. The current Spanner implementation logs every Paxos write twice: once in the tablet’s log, and once in the Paxos log. This choice was made out of expediency, and we are likely to remedy this eventually. Our implementation of Paxos is pipelined, so as to improve Spanner’s throughput in the presence of WAN latencies. By “pipelined,” we mean Lamport’s “multi-decree parliament” [Lamport 1998], which both amortizes the cost of electing a leader across multiple decrees and allows for concurrent voting on different decrees. It is important to note that although decrees may be approved out of order, the decrees are applied in order (a fact on which we will depend in Section 4).

レプリケーションをサポートするため、各スパンサーバーは各タブレット上に単一のPaxosステートマシンを実装します。(設計が複雑過ぎるので後に廃止しましたが、初期のSpannerはタブレットごとに複数のPaxosステートマシンをサポートしていたため、より柔軟なレプリケーション構成が可能でした。)ステートマシンはメタデータを保持し、対応するタブレットにログインします。私たちのPaxosの実装では、規定で10秒という長い生存期間のリーダーをサポートしています。現在のSpannerの実装では、Paxosのすべてのログ書き込みにおいて、タブレットのログに1回、Paxosのログに1回の計2回の書き込みが行われます。この実装は暫定的なもので、いずれ改善する可能性があります。我々のPaxosの実装はパイプライン化されているため、WANレイテンシ存在下でSpannerのスループットを向上させることができます。 パイプライン化(“multi-decree parliament” [Lamport 1998])によって複数の命令にまたがってリーダーを選ぶコストを減らし、異なる命令に同時に投票することが可能になります。命令の承認は順不同で処理されるかもしれませんが、命令の適用は順番に処理されます(同時実行制御に関しては第4章で詳細を説明します)。

The Paxos state machines are used to implement a consistently replicated bag of mappings. The key-value mapping state of each replica is stored in its corresponding tablet.Writes must initiate the Paxos protocol at the leader; reads access state directly from the underlying tablet at any replica that is sufficiently up-to-date. The set of replicas is collectively a Paxos group.

Paxosステートマシンは、マッピングデータの一貫性と冗長化を実装するために使用されます。 各レプリカのキーバリューのマッピング状態は対応するタブレットに保存されます。書き込みは、リーダーによってPaxosプロトコルを用いて実行されます。読み取りは、最新のレプリカのタブレットに対して直接実行されます。レプリカのセットは、まとめてPaxosグループと呼称します。

At every replica that is a leader, a spanserver implements a lock table to implement concurrency control. The lock table contains the state for two-phase locking: it maps ranges of keys to lock states. (Note that having a long-lived Paxos leader is critical to efficiently managing the lock table.) In both Bigtable and Spanner, we designed for long-lived transactions (for example, for report generation, which might take on the order of minutes), which perform poorly under optimistic concurrency control in the presence of conflicts. Operations that require synchronization, such as transactional reads, acquire locks in the lock table; other operations bypass the lock table. The state of the lock table is mostly volatile (i.e., not replicated via Paxos): we explain the details further in Section 4.2.1.

リーダーであるすべてのレプリカで、スパンサーバーにはロックテーブルを用いた同時実行制御が実装されています。ロックテーブルは、2フェーズロックの状態を持っており、キーの範囲をロックの状態にマッピングします。(ロックテーブルを効率的に管理するためには、生存期間の長いPaxosリーダーが存在することが必須です。)BigtableとSpannerの両方で、競合発生状況の楽観的同時実行制御下でパフォーマンスが低下する実行時間の長いトランザクション(たとえば、レポート生成のためには数分かかるかもしれない)のために、トランザクション内の読み取りなど同期が必要な操作のみロック・テーブルのロックを取得し、その他の操作はロックテーブルをバイパスするように設計されています。 ロックテーブルの状態は、基本的に揮発性です(Paxosによってレプリケーションされない)(4.2.1で詳細を説明します)。

At every replica that is a leader, each spanserver also implements a transaction manager to support distributed transactions. The transaction manager is used to implement a participant leader; the other replicas in the group will be referred to as participant slaves. If a transaction involves only one Paxos group (as is the case for most transactions), it can bypass the transaction manager, since the lock table and Paxos together provide transactionality. If a transaction involves more than one Paxos group, those groups’ leaders coordinate to perform two-phase commit. One of the participant groups is chosen as the coordinator: the participant leader of that group will be referred to as the coordinator leader, and the slaves of that group as coordinator slaves. The state of each transaction manager is stored in the underlying Paxos group (and therefore is replicated).

リーダーであるすべてのレプリカで、スパンサーバーには分散トランザクションをサポートするトランザクションマネージャーも実装されています。 トランザクションマネージャーは、パーティシパント・リーダー(グループ内の他のレプリカをパーティシパント・スレーブと呼びます)を実装するために使用されます。トランザクションが1つのPaxosグループのみを含む場合(ほとんどのトランザクションが該当すると思われる)、ロック・テーブルとPaxosがトランザクション性を提供するため、トランザクション・マネージャをバイパスすることができます。 トランザクションに複数のPaxosグループが関与する場合、それらのグループのリーダーは、2フェーズコミットを実行するように調整します。 パーティシパント・グループの1つがコーディネーターとして選ばれます。そのグループのパーティシパント・リーダーはコーディネーターリーダーと呼ばれ、そのグループのスレーブはコーディネータースレーブになります。 各トランザクションマネージャーの状態は、Paxosグループに格納されます。(したがって、レプリケーションされます)

2.2. Directories and Placement

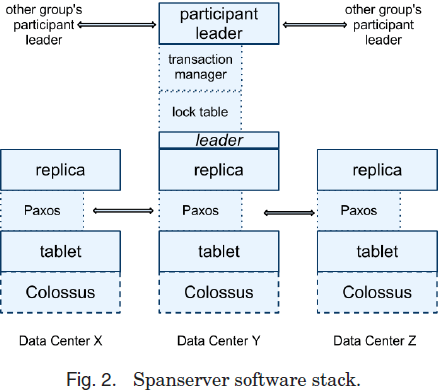

On top of the bag of key-value mappings, the Spanner implementation supports a bucketing abstraction called a directory, which is a set of contiguous keys that share a common prefix. (The choice of the term directory is a historical accident; a better term might be bucket.) We will explain the source of that prefix in Section 2.3. Supporting directories allows applications to control the locality of their data by choosing keys carefully.

Spannerの実装では、キーバリューマッピングデータ上に、ディレクトリと呼ばれるバケット抽象化をサポートしています。これは、共通のプレフィックスを共有する一連の連続したキーのセットです。 (directoryという命名は歴史的な災難で、より良い命名はbucketかもしれません。)そのプレフィックスについては2.3で説明します。ディレクトリのサポートによってアプリケーションは、キーを慎重に選択することで、データのロケーションを制御できます。

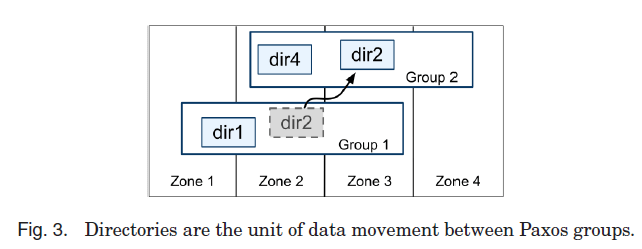

A directory is the unit of data placement. All data in a directory has the same replication configuration. When data is moved between Paxos groups, it is moved directory by directory, as shown in Figure 3. Spanner might move a directory to shed load from a Paxos group; to put directories that are frequently accessed together into the same group; or to move a directory into a group that is closer to its accessors. Directories can be moved while client operations are ongoing. One would expect that a 50MB directory could be moved in a few seconds.

ディレクトリは、データのロケーションの単位です。ディレクトリ内のすべてのデータは、同じレプリケーション構成を持ちます。Paxosグループ間でデータを移動すると、図3に示すように、ディレクトリごとに移動します。Spannerは、不要なロードを削減するためにPaxosグループからディレクトリを移動することがあります。例えば、頻繁に同時アクセスされるディレクトリを同じグループに入れたり、ディレクトリをアクセサに近いグループに移動したりします。クライアント操作が進行中の間でも、ディレクトリを移動することができます。ディレクトリのサイズが50MBの場合、数秒で移動させることが予想されます。

The fact that a Paxos group may contain multiple directories implies that a Spanner tablet is different from a Bigtable tablet: the former is not necessarily a single lexicographically contiguous partition of the row space. Instead, a Spanner tablet is a container that may encapsulate multiple partitions of the row space. We made this decision so that it would be possible to colocate multiple directories that are frequently accessed together.

Paxosグループに複数のディレクトリが含まれている可能性があるということは、SpannerのタブレットがBigtableのタブレットとは異なることを意味します。Spannerのタブレットは、辞書的連続性のある1つのパーティションである必要がありません。代わりに、Spannerのタブレットは、複数のパーティションをカプセル化できるコンテナです。私たちは、頻繁に同時アクセスされる複数のディレクトリを同一ロケーションに配置することができるように、この決定を下しました。

Movedir is the background task used to move directories between Paxos groups [Douceur and Howell 2006]. Movedir is also used to add to or remove replicas from Paxos groups [Lorch et al. 2006] by moving all of a group’s data to a new group with the desired configuration, because Spanner does not yet support in-Paxos configuration changes. Movedir is not implemented as a single transaction, so as to avoid blocking ongoing reads and writes on a bulky data move. Instead, movedir registers the fact that it is starting to move data and moves the data in the background. When it has moved all but a nominal amount of the data, it uses a transaction to atomically move that nominal amount and update the metadata for the two Paxos groups.

Movedirは、Paxosグループ間でディレクトリを移動するためのバックグラウンドタスクです[Douceur and Howell 2006]。SpannerがPaxosの構成変更をまだサポートしていないため、Movedirは、グループの全てのデータを新たに構成したPaxosグループに移動することにより、Paxosグループのレプリカを追加・削除するためにも使用されます[Lorch et al. 2006]。Movedirは、単一のトランザクションとして実装されていないため、大量のデータ移動にもかかわらず進行中の読み取りと書き込みをブロックしません。Movedirはデータの移動を開始しバックグラウンドでデータを移動しているという状態を登録し、ほとんどのデータを移動した後に、トランザクションを使用して残ったあと少しのデータをアトミックに移動し、2つのPaxosグループのメタデータを更新します。

A directory is also the smallest unit whose geographic-replication properties (or placement, for short) can be specified by an application. The design of our placementspecification language separates responsibilities for managing replication configurations. Administrators control two dimensions: the number and types of replicas, and the geographic placement of those replicas. They create a menu of named options in these two dimensions (e.g., North America, replicated 5 ways with 1 witness). An application controls how data is replicated, by tagging each database and/or individual directories with a combination of those options. For example, an application might store each end-user’s data in its own directory, which would enable user A’s data to have three replicas in Europe, and user B’s data to have five replicas in North America.

ディレクトリは、地理的冗長化のプロパティ(またはロケーション)をアプリケーションが指定できる最小単位です。ロケーション記述言語の設計は、レプリケーションの構成管理における責務を分離しています。管理者は2つの構成オプションを制御します。レプリカの数とタイプ、およびレプリカのロケーションです。これらの2つの構成オプションでメニューを作成します(例えば北米で、1つの監視サーバーと5つのレプリカサーバーなど)。アプリケーションは、各データベースまたはディレクトリに、これらの構成オプションの組み合わせを設定することによって、データのレプリケーション方法を制御します。たとえば、各エンドユーザーのデータを独自のディレクトリに格納するよう設定すれば、ユーザーAのデータはヨーロッパに3つのレプリカがあり、ユーザーBのデータは北米に5つのレプリカが存在する等の構成が行えます。

For expository clarity we have oversimplified. In fact, Spanner will shard a directory into multiple fragments if it grows too large. Fragments may be served from different Paxos groups (and therefore different servers). Movedir actually moves fragments, and not whole directories, between groups.

簡潔に説明するために、単純化し過ぎました。実際、Spannerは、ディレクトリが大きくなりすぎると、ディレクトリを複数のフラグメントに分割します。フラグメントは、異なるPaxosグループ(したがって異なるサーバー)から提供されることがあります。Movedirは実際にはグループ間でディレクトリ全体ではなくフラグメントを移動します。

2.3. Data Model

Spanner exposes the following set of data features to applications: a data model based on schematized semirelational tables, a query language, and general-purpose transactions. The move towards supporting these features was driven by many factors. The need to support schematized semirelational tables and synchronous replication is supported by the popularity of Megastore [Baker et al. 2011]. At least 300 applications within Google use Megastore (despite its relatively low performance) because its data model is simpler to manage than Bigtable’s, and because of its support for synchronous replication across datacenters. (Bigtable only supports eventuallyconsistent replication across datacenters.) Examples of well-known Google applications that use Megastore are Gmail, Picasa, Calendar, Android Market, and AppEngine. The need to support an SQL-like query language in Spanner was also clear, given the popularity of Dremel [Melnik et al. 2010] as an interactive dataanalysis tool. Finally, the lack of cross-row transactions in Bigtable led to frequent complaints; Percolator [Peng and Dabek 2010] was in part built to address this failing. Some authors have claimed that general two-phase commit is too expensive to support, because of the performance or availability problems that it brings [Chang et al. 2008; Cooper et al. 2008; Helland 2007]. We believe it is better to have application programmers deal with performance problems due to overuse of transactions as bottlenecks arise, rather than always coding around the lack of transactions. Running two-phase commit over Paxos mitigates the availability problems.

2.3. データモデル

Spannerは、スキーマ定義されたセミリレーショナルテーブル、クエリ言語、および汎用トランザクションをアプリケーションに提供します。これらの機能をサポートしようという動機は、多くの要因によってもたらされました。スキーマ定義されたセミリレーションテーブルと同期レプリケーションをサポートする必要性は、Megastore[Baker et al. 2011]の人気によって支えられています。Googleの中で少なくとも300のアプリケーションは、そのデータモデルがBigtableよりも管理が簡単で、データセンター間の同期レプリケーションをサポートしているため、(パフォーマンスは比較的低いにもかかわらず)Megastoreを使用しています。Megastoreを使用するよく知られているGoogleアプリケーションの例としては、Gmail、Picasa、Calendar、Android Market、AppEngineなどがあります(Bigtableはデータセンター間で結果整合性を保つレプリケーションしかサポートしていません)。インタラクティブなデータ分析ツールであるDremel[Melnik et al. 2010]の人気を考えると、SpannerでSQLライクなクエリ言語をサポートする必要性も明らかでした。最後に、Bigtableには行間トランザクションのサポートが無かったため、頻繁に苦情が寄せられました。Percolator[Peng and Dabek 2010]は、この問題に対処するために組み込まれました。一般的な2フェーズコミットは、それがもたらす性能または可用性の低下と比べて、恩恵が少なすぎると主張する著者もいます[Chang et al. 2008; Cooper et al. 2008; Helland 2007]。我々は、アプリケーションプログラマーにとって、トランザクションの過剰利用が原因でボトルネックが発生しパフォーマンス問題に取り組む事になる方が、トランザクションのサポートが無いせいでコーディング量が増える事よりも良いと信じています。また、Paxos上の2フェーズコミットは可用性の問題を緩和します。

The application data model is layered on top of the directory-bucketed key-value mappings supported by the implementation. An application creates one or more databases in a universe. Each database can contain an unlimited number of schematized tables. Tables look like relational-database tables, with rows, columns, and versioned values. We will not go into detail about the query language for Spanner. It looks like SQL with some extensions to support protocol-buffer-valued [Google 2008] fields.

このデータモデルは、ディレクトリバケット内のキーバリューデータ上に実装されています。アプリケーションは、ユニバース内に1つ以上のデータベースを作成します。各データベースには、無制限のスキーマ定義されたテーブルを含めることができます。テーブルは、行、列、およびバージョニングされた値を持つリレーショナルデータベーステーブルのように見えます。Spannerのクエリ言語について詳しくは触れません。Spannerのクエリ言語は、Protocol Buffers[Google 2008]をサポートする拡張機能を備えたSQLのようなものです。

Spanner’s data model is not purely relational, in that rows must have names. More precisely, every table is required to have an ordered set of one or more primary-key columns. This requirement is where Spanner still looks like a key-value store: the primary keys form the name for a row, and each table defines a mapping from the primary-key columns to the non-primary-key columns. A row has existence only if some value (even if it is NULL) is defined for the row’s keys. Imposing this structure is useful because it lets applications control data locality through their choices of keys.

Spannerのデータモデルは、行が名前を持たなければならないという点で、純粋にリレーショナルではありません。より正確には、すべてのテーブルには、ソート済み主キー列セットが必要です。この要件は、Spannerがキーバリューストアのように見える面です。主キーは行の名前を表し、各テーブルは主キー列から非主キー列へのマッピングを定義します。行は、その行のキーに何らかの値(NULLであっても)が定義されている場合にのみ存在します。この実装は、アプリケーションがキーの選択によってデータのロケーションを制御できるという利便性をもたらします。

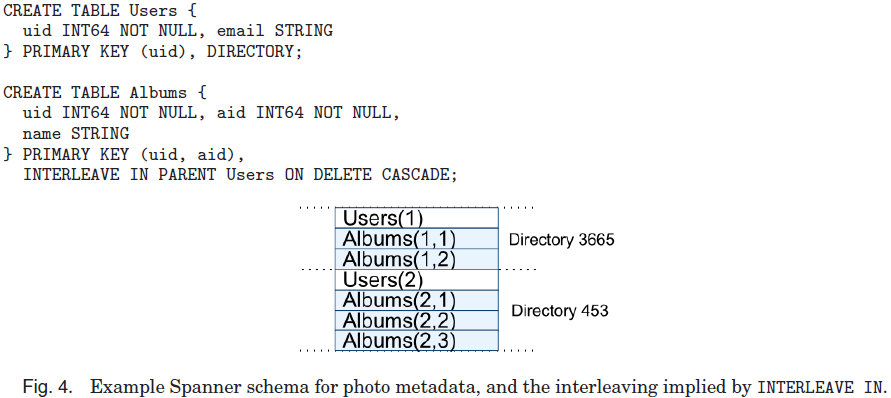

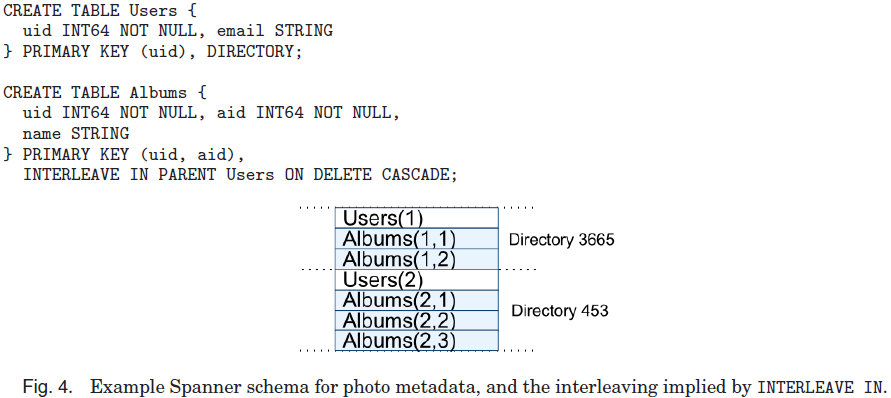

Figure 4 contains an example Spanner schema for storing photo metadata on a per-user, per-album basis. The schema language is similar to Megastore’s, with the additional requirement that every Spanner database must be partitioned by clients into one or more hierarchies of tables. Client applications declare the hierarchies in database schemas via the INTERLEAVE IN declarations. The table at the top of a hierarchy is a directory table. Each row in a directory table with key K, together with all of the rows in descendant tables that start with K in lexicographic order, forms a directory. ON DELETE CASCADE says that deleting a row in the directory table deletes any associated child rows. The figure also illustrates the interleaved layout for the example database: for example, Albums(2,1) represents the row from the Albums table for user id 2, album id 1. This interleaving of tables to form directories is significant because it allows clients to describe the locality relationships that exist between multiple tables, which is necessary for good performance in a sharded, distributed database. Without it, Spanner would not know the most important locality relationships.

図4に、ユーザーごと、アルバムごとに写真のメタデータを保存するSpannerスキーマの例を示します。スキーマ言語はMegastoreに似ていますが、すべてのSpannerデータベースはクライアントによって1つ以上のテーブル階層構造に分割される必要があります。クライアントアプリケーションは、INTERLEAVE IN宣言によってデータベーススキーマの階層を宣言します。階層の最上位にあるテーブルはディレクトリテーブルです。キーKを持つディレクトリテーブルの各行は、辞書順にKで始まる子テーブルのすべての行と共に、ディレクトリを形成します。 ON DELETE CASCADEでディレクトリテーブル内の行を削除すると、関連する子の行が削除されます。この図は、サンプルデータベースのインターリーブ(追記:別々のディレクトリに配置)されたレイアウトも示しています。たとえば、Albums(2,1)は、ユーザーID 2、アルバムID 1のAlbumsテーブルの行を表します。ディレクトリを形成するためのこのテーブルのインターリーブは、クライアントが複数のテーブル間に存在するロケーションの関係性を指定することを可能にするために重要で、分割・分散されたデータベースにおいて良好な性能を得るためにも重要です。それがなければ、Spannerは最も重要なロケーションの関係性を管理できません。

blog.game-programmer.jp